اگر با دنیای سئو سایت کمی آشنا باشید، حتما دربارهی رباتهای گوگل (Googlebots) یا خزندههای وب گوگل (Google’s web crawler) چیزهایی شنیدهاید. ربات خزنده گوگل چیست؟ چه میکند؟ آیا رباتهای گوگل انواعی دارند؟ آیا باید سایت را برای خزندهها هم بهینه کرد؟ اگر بله، چطور؟ این مقاله به این سوالات جواب میدهد و سهم و اهمیت خزندههای گوگل در سئو سایت را روشن میکند.

عوامل مختلفی برای سئو سایت باید رعایت شوند. کارشناس سئو باید براساس استانداردها و راهنماهای موتورهای جستجو پیش برود: طراحی سایت و طراحی تجربه کاربری سایت باید ویژگیهایی داشته باشند. محتواهای سایت باید اصیل و باکیفیت باشند و … . بخش زیادی از استانداردهایی که موتورهای جستجو (مخصوصا گوگل) برای سایتها درنظر گرفتند برای این است که کاربر چیزی را که میخواهد راحتتر و سریعتر پیدا کند.

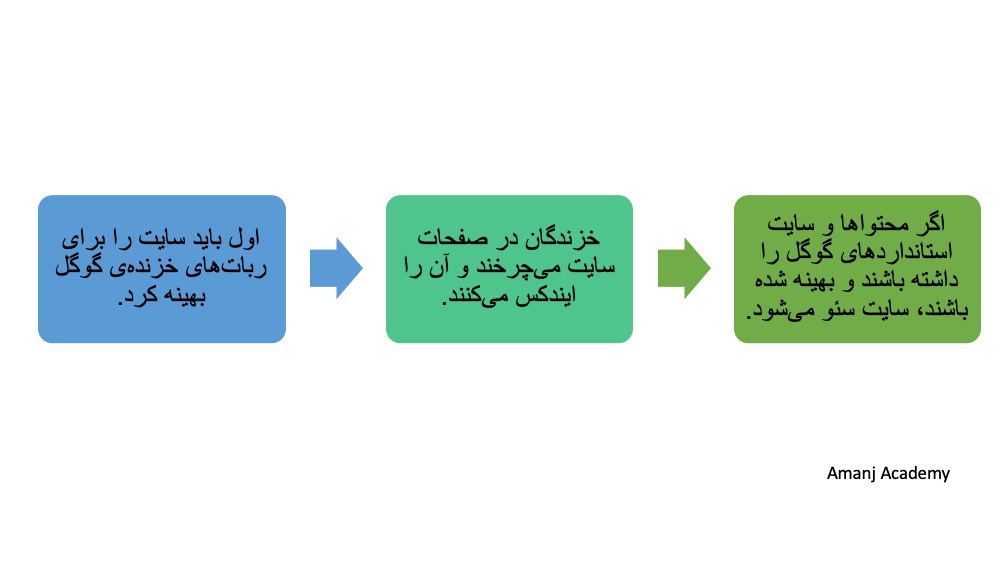

اما علاوهبر کاربر و قبلاز کاربر، خزندهها باید چیزهایی را که برای موتورهای جستجو مهم است در سایت بیابند و ببینند.خزندههای گوگل (و موتورهای جستجو درکل) وظایف مهمی را بهعهده دارند و اگر سایت برای خزندهها بهینه نشده باشد، بعید است اساسا سئو شود. این نکته را باید بگویم که این رباتها یک اسم اصلی و عام دارند: ربات گوگل. ولی در وب فارسی و انگلیسی نامهای دیگری نیز برای رباتهای گوگل وجود دارد: عنکبوت یا عنکبوتهای گوگل، خزندهها، رباتهای خزنده، باتهای خزندهی گوگل، رباتهای جستجوی گوگل یا کرالرهای گوگل.

برای اینکه بیشتر بااهمیت خزندههای گوگل و کاری که در سئو سایت انجام میدهند آشنا شوید باید بدانید موتورهای جستجو چگونه کار میکنند، یعنی چگونه صفحات سایت را میبینند و رتبهبندی میکنند. بههمیندلیل، پیشنهاد میکنم مقالهی «موتور جستجو چطور کار میکند؟» را بخوانید.

آنچه در این نوشته خواهیم داشت

ربات خزنده گوگل چیست؟

همهی موتورهای جستجو برای گشتن در صفحات سایت از باتهای مخصوصبه خودشان استفاده میکنند؛ مثلا، خزندههای موتور جستجوی یاهو Slurp نام دارند. در این مقاله فقط دربارهی رباتهای جستجوی گوگل صحبت میشود، چون گوگل محبوبترین موتور جستجوی دنیاست.

شما سایتی را میسازید و بهترین محتواها و اطلاعات دنیا را در درون آن قرار میدهید. طبیعتا این کار را برای این میکنید که کاربران به سایت شما بیایند و آن را ببینند. بهاحتمال خیلی زیاد، کاربر از نتایج جستجوی گوگل به سایت شما میرسد. درواقع، گوگل است که سایت شما را به کاربر نشان میدهد. پس طبیعی است که اول گوگل باید سایت و محتوای آن را ببیند.

گوگل برای اینکه بفهمد شما در هر صفحه از سایت چه اطلاعاتی قرار دادید باید آن صفحه را Index کند. یعنی آن را ببیند، تمامی محتواهایی را که در آن قرار داده شده است بخواند و بفهمد و آن را در لیست صفحاتی که دیده و میشناسد قرار دهد. همهی آن کارها را رباتهای خزنده برای گوگل انجام میدهند.

سایتهای مرجع در سئو سایت خزندههای گوگل را تعریف کردند. اما بهنظر من بهترین و جامعترین تعریف را سایت مرجع ahrefs ارائه کرده است:

Googlebot is the web crawler used by Google to gather the information needed and build a searchable index of the web. Googlebot has mobile and desktop crawlers, as well as specialized crawlers for news, images, and videos.

باتهای گوگل خزندههای وب هستند که اطلاعات لازم برای ساختن فهرستی قابلجستجو از صفحات وبسایت را جمعآوری میکنند. باتهای گوگل دو دسته خزندهی اصلی دارند: خزندگان نسخهی موبایل سایت و خزندگان نسخهی دسکتاپ. البته، خزندگان دیگری هم هستند که بهصورت تخصصی فقط اخبار، عکسها و ویدئوها را میبینند.

چرا خزندگان گوگل مهم هستند؟

فهرست جستجوی گوگل (Google Search Index) را خزندهها میسازند. گوگل با استفادهاز کرالرها لیستی از تمامی صفحات سایتهای موجود در اینترنت فراهم میکند تا بعد آنها را رتبهبندی کند. باتهای گوگل مثل یک کاربر صفحه را میبینند و در فهرست قرار میدهند. پس خزندگان گوگل و اینکه سایت برای آنها بهینه شده باشد مهم است چون اگر عنکبوتها صفحات سایت را نبینند و در آن نخزند، گوگل هم آنها را نمیبیند و درنتیجه صفحه و سایت جایی (رتبهای) در نتایج جستجوی گوگل نخواهند داشت.

سوالات بسیار مهمی دربارهی شیوهی کار رباتهای جستجوی گوگل پیش میآید: آیا کارشناس سئو یا وبمستر میتواند کرالرها را کنترل کند یا همهچیز دراختیار گوگل است؟ میشود صفحاتی را به خزندگان (گوگل) نشان نداد؟ آیا خزندگان هرروز به یک سایت سر میزنند و دنبال صفحات جدید در آن میگردند؟ رباتها چه مدت در یک سایت میمانند؟

بله، کارشناس سئو میتواند تاحدی رفتار خزندگان گوگل در سایت را کنترل کند و بعضی صفحات یا عکسها را به او نشان ندهد. همهی کارشناسان سئو با فایل robots.txt آشنا هستند. این فایل درواقع لیستی از صفحات سایت است که شما میخواهید کراولرها (موتورهای جستجو) آنها را ببینند. در همین فایل ممکن است به خزندگان اجازه ندهید و بگویید که به صفحات مشخصی از سایت نروند.

درادامه، نکات مهمی که کارشناسان سئو سایت دربارهی شیوهی کارکردن رباتهای جستجوی گوگل باید بدانند، ذکر شده است.

ربات های خزندهی گوگل چطور کار میکنند؟

- کارشناس سئو هرگز نباید فراموش کند، بهغیراز صفحات یا محتواهایی که در فایل robots.txt از خزندگان پنهان کرده است، عنکبوتهای گوگل هرچند ثانیه یکبار به سایتها سر میزنند و در آن میچرخند و بهدنبال چیزهای جدید میگردند.

- کارشناس سئو نمیتواند برای گوگل تعیین کند که کرالرها چهزمانی، چندبار و برای چه مدتی در سایت بخزند.

- هرچه دامنه سایت معتبرتر باشد، خزندگان وقت بیشتری را برای خزیدن در آن سایت اختصاص میدهند و صفحات (محتواهای) بیشتری را میبینند و Index میکنند (یعنی crawl budget آن سایت زیادتر است).

- خزندگان گوگل شاید در همهی صفحات یک سایت نروند. باتهای گوگل اول براساس فایل robots.txt و بعد براساس نقشهی سایت (Sitemap) در میان صفحات سایت میچرخند. نقشه سایت برای هدایت کرالرها بسیار مفید و مهم است. نقشه سایت منظم و ساختارمند و روشن کار رباتها را راحتتر و سریعتر میکند و آنها را زودتر به صفحات و محتواهای مهم سایت میرساند.

ربات های گوگل چند نوع هستند؟

قبلاز اینکه به جالبترین و کاربردیترین بخش این مقاله برسیم، بهتر است توضیحی کوتاه دربارهی انواع رباتهای گوگل داده شود. همانطور که اشاره شد، موتورهای جستجو برای دیدن صفحات و محتواهای آنها و چرخیدن در سایت (ازطریق لینکسازی داخلی) از برنامهها و ماشینهایی استفاده میکنند که معمولا به آنها خزنده یا رباتهای خزنده گفته میشود. کارشناس سئو هر سایتی میتواند برای خزندگان قوانینی مشخص کند (فایل robots.txt).

در آن فایل کارشناس میتواند مشخص کند ورود نوع خاصی از کراولرها به سایت ممنوع است. او برای تعریفکردن قوانین برای خزندگان از نام خاص هرکدام استفاده میکند. باتهای خزنده دردرجهیاول براساس اینکه متعلق به کدام موتور جستجو هستند و دردرجهیدوم کاری که انجام میدهند با پسوندی (user-agent) شناخته میشوند. برای مثال خزندگان گوگل که فقط محتواهای ویدئویی را میبینند و فهرست میکنند با این نام شناخته میشوند: Googlebot-Video یا Googlebot-News خزندگانی هستند که فقط اخبار را ایندکس میکنند.

اگر کارشناس سئو سایتی به هر دلیلی نخواهد ویدئوهای سایتش ایندکس شوند، بهراحتی میتواند آن خزندگان (Googlebot-Video) را از ورود به سایت منع کند. طبیعی است همهی انواع خزندگان به یکاندازه مهم نیستند و کارشناس سئو چون میخواهد تمام متحواهای سایتش دیده شود و در نتایج جستجو رتبه بگیرد، دلیلی ندارد بخواهد خزندگان گوگل را از ورود به سایت منع کند. (میتوانید لیست مهمترین باتهای گوگل را در developers.google.com ببینید.)

چطور سایت را برای عنکبوت های گوگل بهینه کنیم؟

اگر کارشناس سئو میخواهد سایت بدون مشکل و دردسر ایندکس شود، باید کار را برای خزندگان گوگل راحت کند. یعنی کرالرها برای ورود به سایت و چرخیدن در صفحات نباید مشکل یا مانعی داشته باشند. بههمیندلیل، قبلازاینکه کارهای مربوطبه سئو سایت انجام شود، سایت را باید برای عنکبوتهای گوگل بهینه کرد. (چون قبلا دربارهی اهمیت فایل robots.txt و سایت مپ صحبت شده است، در موارد زیر به آنها اشاره نکردم.)

۱. سایت نباید از نظر فنی و تکنیکی کار را برای خزندگان گوگل سخت کند

در طراحی سایت ممکن است از زبانهای برنامهنویسی مختلف و همچنین تکنولوژیهای مختلفی استفاده شود. معمولا برای افزایش سرعت سایت و پویاتر و تعاملیترکردن آن از AJAX و زبان برنامهنویسی جاوااسکریپ کمک گرفته میشود. گوگل بارها اعلام کرده است که جاوااسکریپت ممکن است کار را برای کرالرها سخت کند و این باعث شود آنها نتوانند تمام صفحات را ببینند یا کاملا در سایت بخزند. پس، کارشناس سئو سایت قبلاز هرچیز باید با تیم فنی و توسعهدهندگان سایت صحبت کند و مطمئن شود که مانعی فنی برای کار خزندگان گوگل در سایت وجود ندارد.

۲. نباید از لینکسازی داخلی و تولید محتوای باکیفیت غافل شد

فکر کنم روشن شده است که چرا به رباتهای گوگل عنوان عنکبوت داده شده است. خزنده وقتی وارد صفحهای از سایت میشود، در هر لینکی (چه داخلی یعنی به دیگر صفحات همان سایت یا لندینگ پیجها چه خارجی یعنی به سایتهای دیگر) که در آن صفحه وجود داشته باشد هم میرود. یعنی محتوای لینکها (صفحات) را نیز میبیند. بههمیندلیل توصیه میشود که لینکهای خارجی ازنوع Nofollow باشد تا عنکبوت از سایت خارج نشود و به گشتن میان صفحات همان سایت ادامه دهد.

بههمیندلیل، لینکسازی داخلی باید بادقت انجام شود تا خزنده درمیان صفحات و محتواهای مختلف بچرخد و صفحات بیشتری را ببیند. یادتان باشد که crawl budget هر سایت بینهایت نیست. یعنی محدود است و بات خزنده هربار که به سایت سر میزند میتواند فقط تعدادی از صفحات را ببیند و ایندکس کند. ازطرف دیگر، کرالرهای گوگل بهدنبال محتوای باکیفیت و بهروز نیز هستند. هرچه خزندگان گوگل یک صفحه از سایت را بیشتر ببینند و محتوای آن صفحه بهروز و باکیفیت باشد، شانس اینکه آن صفحه جایگاه بهتری بگیرد بیشتر میشود.

۳. وضعیت حضور و فعالیت باتهای گوگل در سایت باید بهدقت زیرنظر گرفته شود

کار خزندگان گوگل و سهمی که در سئو سایت دارند، آنقدر مهم است که در Google Search Console هم بخشی به آنها اختصاص داده شده است. کارشناس سئو میتواند وضعیت نقشه سایت، ارورها و همچنین آمار خزندگان (Crawl Stats) را مشاهده کند. باکمکگرفتن از سرچ کنسول بهراحتی میشود خطاهای کراول را یافت و برطرف کرد (در راهنمای جامعی باعنوان «هرآنچه که باید از خطاهای کراول یا crawl errors بدانید + راهنمای رفع آنها» مفصل دربارهی این خطاها صحبت شده است).

در بخش Settings سرچ کنسول گزینهای وجود دارد بهنام Crawl Stats. در آن گزارش کاملی از اینکه خزندگان گوگل چطور و چندبار در بازهی زمانی مشخصی در سایت خزیدند وجود دارد. کارشناس سئو در همین ابزار میتواند از گوگل بخواهد تا نرخ خزیدن یا Crawl rate را کمتر کند. نرخ خزیدن تعداد درخواستهایی است که باتهای گوگل هنگام خزیدن از سایت دارند. وقتی این تعداد بالا باشد ممکن است مشکلاتی برای سایت پیش بیاید. اگر کارشناس سئو بخواهد مطمئن شود که خزندگان صفحهای را دیدند و آن صفحه ایندکس شده است، میتواند در سرچ کنسول این موضوع را بررسی کند. این امکان نیز وجود دارد که اگر تغییراتی در صفحهی ایندکسشده ایجاد شده است از گوگل خواست تا کراولرها را دوباره به آن صفحه بفرستد.

جمعبندی و نتیجهگیری

۱. اگر سایت برای خزیدن رباتهای خزندهی گوگل بهینه نشده باشد، صفحات سایت در گوگل ایندکس نخواهند شد. و درنتیجه آن سایت سئو نخواهد شد.

۲. تمام موتورهای جستجو برای دیدن محتواهای صفحات سایتها در وب از رباتها و خزندگان استفاده میکنند.

۳. برای خزندگان گوگل میشود قوانینی تعریف کرد (فایل robots.txt) که مشخص میکند چهچیزهایی را در یک سایت ببینند و چهچیزهایی را نبینند. مسیر حرکت خزندگان در سایت را با نقشه سایت میشود مشخص کرد.

۴. برای نوشتن این مقاله از سایتهای مرجع استفاده شده است. به چندتا از آنها در متن لینک دادم که توصیه میکنم حتما آنها را بخوانید. علاوهبر آنها، برای مطالعهی بیشتر میتوانید developers.google.com را نیز مطالعه کنید.

۵. همانطور که روشن شد بحث دربارهی رباتهای خزندهی گوگل هم در مفاهیم پایهای سئو و هم در کار با ابزارها و تحلیل در سئو جای دارد. بههمیندلیل، در آموزش سئو سایت در دو سرفصل مهم (مقدمات و مفاهیم پایه و تحلیل در سئو) دربارهی کرالرهای گوگل آموزشهایی داده میشود.

۶. کارشناس سئو بدون کمک و همراهی تیم فنی و طراح سایت نمی تواند سایت را برای خزندگان گوگل بهینه کند. برای هر وب دیزاینری لازم و ضروری است که با مبانی سئو سایت آشنا باشد. برای همین است که در دوره آموزش طراحی وبسایت سرفصلی بانام مبانی سئو وجود دارد.